Sehbehinderung: Navigation ganz anders

Author: Gerd Grüner

Einfach Augen fest zumachen, Google Maps auf dem Smartphone einschalten und von A nach B navigieren? Dieser Versuch geht sicher schief. Für blinde und sehbehinderte Menschen sind solche Einschränkungen aber der Alltag. Können digitale Technologien für Nutzer mit Handicap tatsächlich ein Hilfsmittel sein? Kann KI den Blindenhund ersetzen?

Digitale Technologien können blinden und sehbehinderten Menschen das Leben im Alltag einfacher, bequemer und sicherer machen. Die Nachfrage dazu wäre vorhanden. Die Europäische Blindenunion mit Sitz in Paris geht davon aus, dass es auf dem Gebiet des geografischen Europa über sechs Millionen blinde und 24 Millionen sehbehinderte Menschen gibt. In Deutschland gab es dem Statistischen Bundesamt zufolge am 31. Dezember 2019 rund 453.000 sehbehinderte Menschen, was nach einer Definition des Deutschen Blinden- und Sehbehindertenverbandes bedeutet, dass die Betroffenen auf dem besseren Auge nur noch über ein Sehvermögen von 30 Prozent oder über eine entsprechende Einschränkung des Gesichtsfelds verfügen. Dazu kommen rund 51.000 hochgradig sehbehinderte (Sehvermögen fünf Prozent) und 77.000 blinde Menschen (Sehvermögen zwei Prozent).

Digitale Technologien eröffnen Menschen mit Handicap neue Handlungsfelder

Das Angebot an Hilfsmitteln reicht vom Farberkennungsgerät mit Sprachausgabe über sprechende Waagen, Uhren und elektronische Füllhöhenanzeiger für Behälter bis hin zu sogenannten Braillezeilen, die sich an den Computer anschließen lassen und dann Zeile für Zeile den Bildschirmtext in Blindenschrift wiedergeben. Die OrCam MyEye zum Beispiel ist eine Mini-Kamera, die sich am Brillenbügel fixieren lässt und Texte auf Displays, Schildern oder Büchern erkennt und über einen integrierten Lautsprecher vorliest. Das Gerät soll zudem Geldscheine erkennen und Barcodes auf Verpackungen lesen. Digitale Technologien können demnach Menschen mit Handicaps neue Handlungsfelder eröffnen. Können sie aber auch einen Blindenhund oder einen Blindenstock ersetzen? Gibt es Navigationssysteme, die zuverlässig und sicher von zu Hause zum Bahnhof oder in einem Museum zur Toilette navigieren?

Tatsächlich ist die Navigation für Menschen mit visuellen Einschränkungen ein Arbeitsfeld, auf dem Wissenschaftler und Ingenieure längst alle Register ziehen. Dass es dabei immer wieder Anknüpfungen zur digitalen Navigation in der Automobilindustrie gibt, ist kein Zufall. Hier wie dort stellen sich die gleichen Grundfragen: Wo ist der aktuelle Standort? Welches Ziel steht an? Wie ist die beste Route dorthin? Welche Hindernisse und Einschränkungen sind zu erwarten? Menschen mit Sehbehinderung benötigen allerdings mehr Informationen als Sehende, um sich sicher im Straßenverkehr zu bewegen. Eine Navigation mit Google Maps würde jedenfalls einen blinden Menschen in der Stadt nicht sicher von A nach B lotsen können – schließlich würde das System dem Nutzer keine Infos über Bodenstrukturen, Niveauunterschiede auf Gehwegen und Plätzen, Hindernisse und Bodenindikatoren zur Verfügung stellen. Ideal wären Navigationssysteme, die eigens auf den jeweiligen Grad der Sehbehinderung angepasst sind. Der Markt für diese Systeme ist bislang jedoch sehr überschaubar – gerade blinde und stark sehbehinderte Menschen sind daher vorerst weiter auf den Blindenführhund oder den weißen Langstock zur Erkennung von Bodenhindernissen angewiesen.

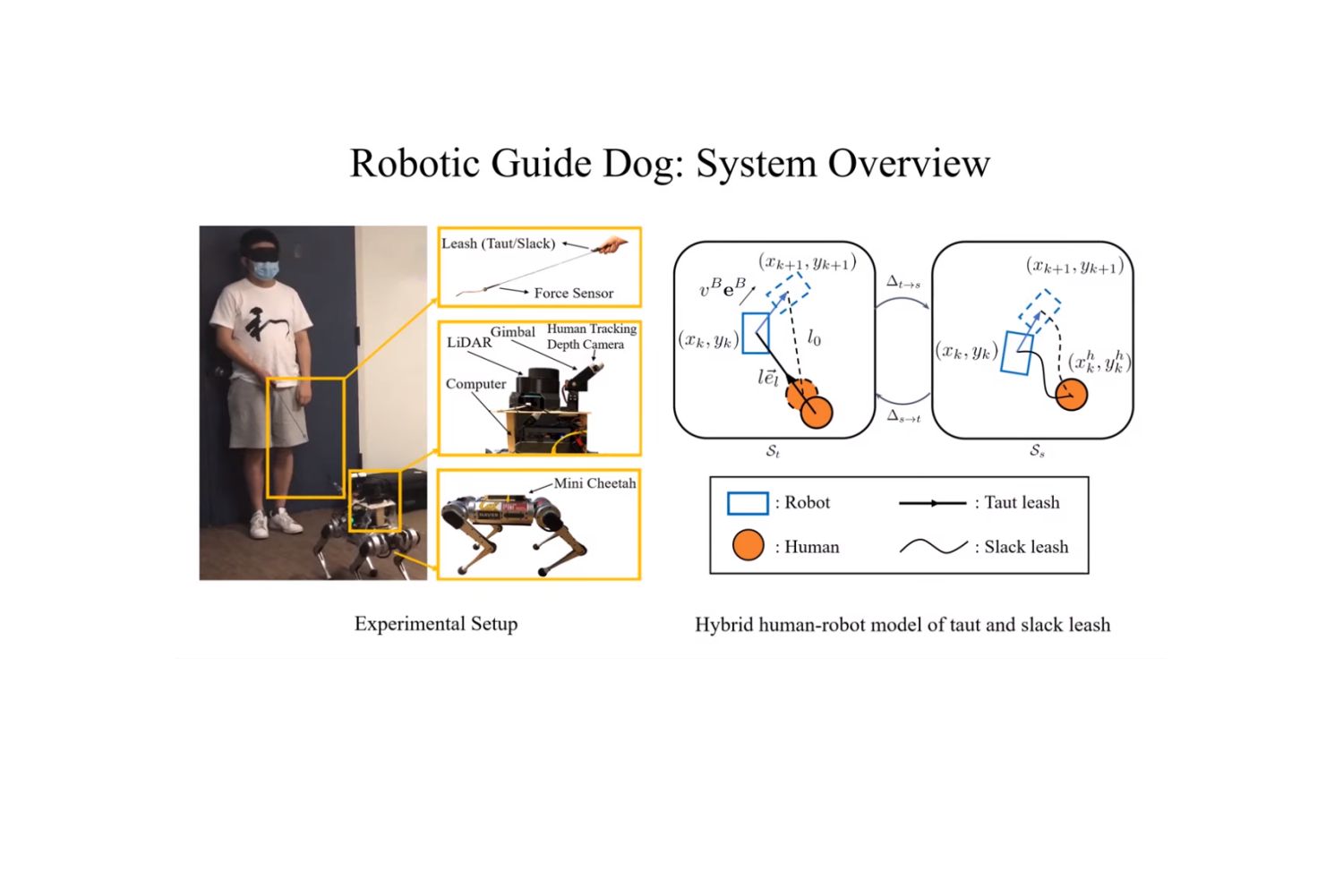

Roboter und KI-Drohne machen dem Blindenführhund Konkurrenz

Allerdings nehmen findige Wissenschaftler längst auch diese Standardhilfsmittel ins Visier. Stöcke mit im Griff integrierter Ultraschall-Ausstattung können in Kopf- oder Brusthöhe befindliche Hindernisse wie tief hängende Äste oder offene Lkw-Laderampen detektieren und den Nutzer mit einer Vibrationssignal warnen. Vollends zum Hightech-Tool wird der Langstock, wenn Kamera, GPS-Antenne und Laser-Technologie ins Spiel kommen. Forscher an der Stanford University in Kalifornien haben einen Prototyp entwickelt, der Hindernisse und Ausweichrouten entweder durch akustische Signale, durch Vibration oder eine Bewegungskraft anzeigt. An der Universität Berkeley wiederum experimentieren Wissenschaftler mit einem vierbeinigen Roboter, der mit künstlicher Intelligenz und Lidar-Sensoren bestückt ist und sehbehinderte Menschen effektiver navigieren soll als ein Hund aus Fleisch und Blut. Der Robo-Dog soll sich dank selbstlernender Algorithmen Tag für Tag besser auf den Nutzer einstellen und so mit der Zeit zum nahezu perfekten Blindenführer avancieren. Eine fliegende Variante des Blindenführhunds haben Wissenschaftler aus China vor Kurzem gemeinsam mit dem Karlsruher Institut für Technologie einem Feldtest unterzogen. Der Nutzer hält die KI-Drohne an der Leine, während sie mit ihrer Kamera die Umgebung scannt. Das System erkennt begehbare Wege, Hindernisse und Ampeln. Es leitet den Nutzer auf der geplanten Route und erteilt per Headset Audioanweisungen.

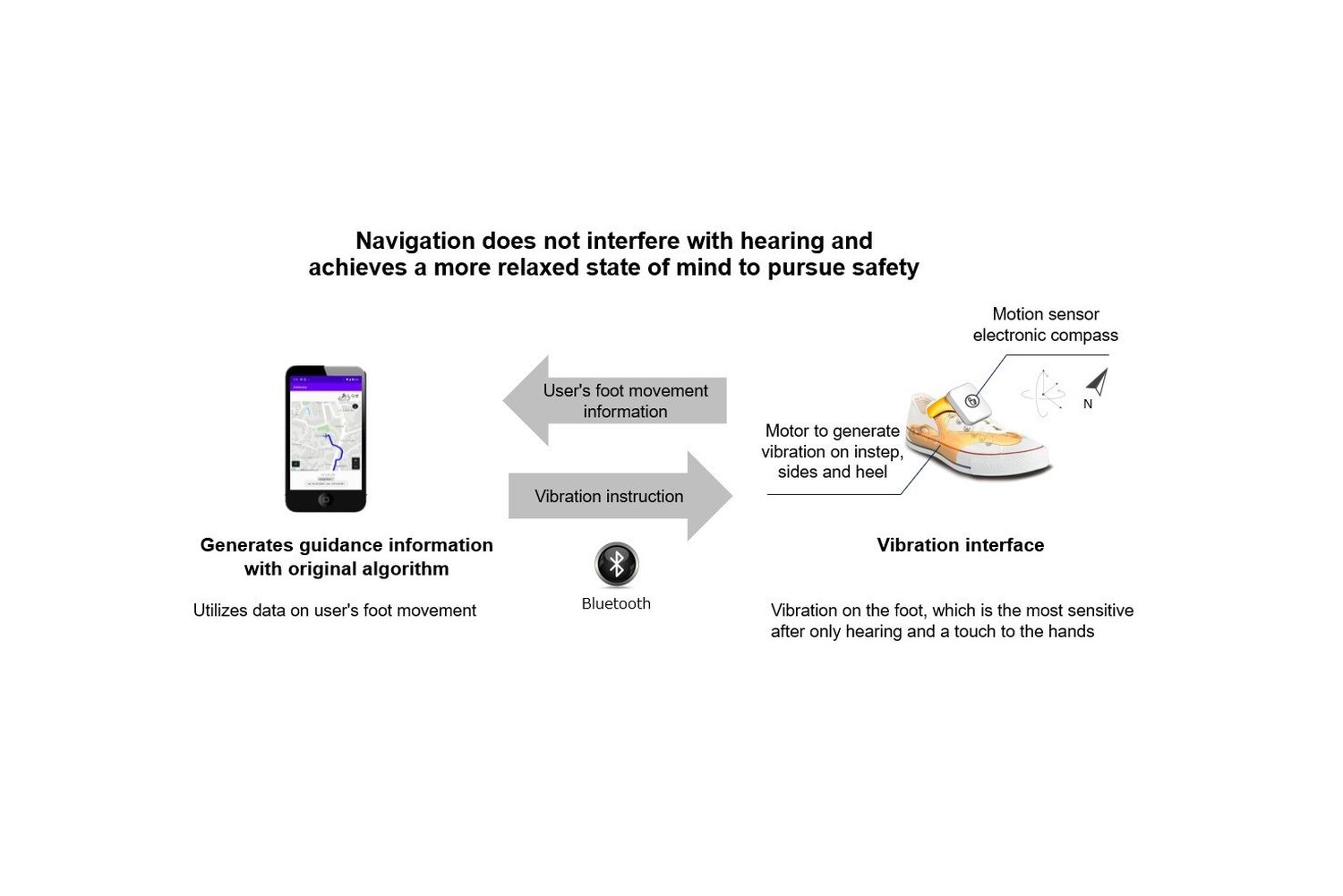

Wearables – Navigation im Schuhwerk

Das japanische Start-up Ashirase entwickelt derzeit ein in Schuhen integriertes Navigationssystem, das Menschen mit Sehbehinderung beim Gehen unterstützt. Es besteht aus einer Smartphone-App und einer dreidimensionalen Vibrationsvorrichtung mit Bewegungssensor, die im Inneren des Schuhs angebracht wird. Basierend auf der mit der App voreingestellten Route, vibriert das System, um Navigationsanweisungen zu geben. Soll der Nutzer geradeaus gehen, wird eine Vibration am vorderen Fuß ausgelöst, wenn der Nutzer rechts oder links abbiegen soll, wird eine Vibration auf der linken oder rechten Seite ausgelöst. Auf Künstliche Intelligenz im Schuhwerk setzt die niederösterreichische Firma Tec-Innovation in einer Kooperation mit dem Institut für Maschinelles Sehen und Darstellen der TU Graz. Der aktuelle Prototyp ist ein Schuh mit Ultraschall-Sensoren an der Schuhspitze und einer integrierten Kamera. Das System arbeitet mit Algorithmen, die mittels Machine Learning darauf trainiert sind, aus Kamerabildern aus der Fußperspektive einen hindernisfreien und damit gefahrlos begehbaren Bereich zu erkennen.

Routago – KI im Einsatz für sehbehinderte Fußgänger

Das Start-up „Routago“ hat gemeinsam mit dem Forschungspartner Karlsruher Institut für Technologie (KIT) eine mit Künstlicher Intelligenz arbeitende Technologieplattform entwickelt, die blinde und sehbehinderte Menschen mit Tools und Hilfsmitteln im Verkehr unterstützen soll. Die Navigation berücksichtigt Straßenseiten, Gehwege, Parks und Fußgängerzonen. Sie führt den Nutzer zu sicheren Straßenüberquerungen an Ampeln, Zebrastreifen, Fußgängerbrücken sowie Unterführungen. Das System kombiniert Navigation, Objekterkennung, Umgebungsinformationen und individuelle Wegeverwaltung. Dazu vervollständigt es die vorhandenen Geodaten durch eine algorithmische Ergänzung speziell für Fußgänger. Die Weg-Anweisungen hören die Nutzer via Voice-Over.

NaviLens – eine digitale Karte für Blinde

NaviLens aus dem spanischen Murcia schreibt sich eine Lösung mit dem Smartphone auf die Fahnen, die Busfahren, Sightseeing und Shopping für Menschen mit Sehstörung möglich machen sollen. Herzstück der Anwendung sind spezielle, rund 20 Quadratzentimeter große QR-Codes, die sich per Smartphone-Kamera aus bis zu zwölf Meter Entfernung selbst aus unterschiedlichen Winkeln erkennen lassen. Die App erkennt die Codes auch ohne Fokussierung. Sie lädt die verlinkten Informationen blitzschnell herunter und gibt sie den Benutzern als Sprachanweisungen aus. Die Technologie wird derzeit in den Verkehrssystemen der Städte Barcelona, Madrid und Murcia eingesetzt. New York und Los Angeles testen das System derzeit in einer U-Bahn-Station und in einem Bahnhof.

Indoor-Navigation – everGuide vom Fraunhofer-Institut FOKUS

Die Indoor-Navigations-App „everGuide“ des Berliner Fraunhofer-Instituts FOKUS soll den Nutzern auch in komplexen und weitläufigen Gebäuden eine sichere Navigation ermöglichen. Damit die Gebäudedaten für die App auf dem neuesten Stand sind, schicken die Fraunhofer-Wissenschaftler einen Roboter mit Kameras und Laserscannern auf die Reise, der eine exakte digitale Karte erstellt. Eine Schlüsselrolle bei der Navigation spielt das Smartphone. Zur Bestimmung des Standorts kommen zum Beispiel Beschleunigungs- und Drehratensensoren zum Einsatz, die die Ab- und Zunahme der Geschwindigkeit und die Lageveränderung des Geräts erfassen. Weiteren Input geben im Gebäude installierte Schilder mit speziellen QR-Codes, die automatisch von der Kamera des Smartphones erkannt werden und ebenfalls zur Positionsbestimmung dienen. Die Navigationssoftware auf dem Smartphone fusioniert die verschiedenen Daten und passt die Navigation an. Feldtests mit der Fraunhofer-App finden derzeit im Haus der Gesundheit und Familie in Berlin, im Rathausgebäude der nordrhein-westfälischen Stadt Solingen und in der Ausländerbehörde in Köln statt.

Peak Vision – mit dem Smartphone die Sehschärfe messen

Das britische Unternehmen Peek Vision hat vor fünf Jahren mit Peek Acuity eine App auf den Markt gebracht, die als zertifiziertes medizinisches Hilfsmittel zur Überprüfung des Sehvermögens in mehr als 190 Ländern verfügbar ist. Geschulte Laien können mit dem Diagnoseverfahren Peek Acuity mit einem einfachen Smartphone die Sehschärfe von Patienten messen und die Daten zur Ferndiagnose an Ärzte weiterleiten. Dazu wird dem Probanden auf dem Smartphone-Display – wie auf einer klassischen Sehtafel beim Augenarzt – der Buchstabe E in verschiedenen Ausrichtungen und Größen gezeigt. Die Testperson sitzt drei Meter vom Bildschirm entfernt auf einem Stuhl, hält sich ein Auge zu und gibt per Fingerzeig an, in welche Richtung die Öffnungen des Buchstabens E zeigen. Ist der Test abgeschlossen, zeigt die App den errechneten Wert für die Sehschärfe an.